Immagini Getty | Alessandro Angolo

Apparentemente Google ha pubblicato accidentalmente su GitHub un’ampia serie di documenti tecnici interni, che spiegano in parte il modo in cui il motore di ricerca classifica le pagine web. Per la maggior parte di noi, la domanda riguardante il posizionamento nei risultati di ricerca è semplicemente “I miei risultati web sono buoni o cattivi?”, ma la comunità SEO è entusiasta di sbirciare dietro le quinte e sollevarsi in armi poiché i documenti sembrano contraddire alcuni dei documenti forniti da Google. gliel’ha detto in passato. La maggior parte dei commenti sulla fuga di notizie provengono da esperti SEO. Rand Fishkin E Mike King.

Google ha confermato l’autenticità dei documenti il bordo“Mettiamo in guardia dal fare ipotesi imprecise sulla ricerca basate su informazioni fuori contesto, obsolete o incomplete”, ha affermato “Abbiamo condiviso informazioni complete su come funziona la ricerca e sui tipi di fattori misurati dai nostri sistemi, lavorando anche su proteggere l’integrità dei nostri risultati dalla manipolazione.”

La cosa divertente della pubblicazione accidentale su GoogleAPI GitHub è che, anche se si tratta di documenti interni sensibili, Google li ha tecnicamente rilasciati con la licenza Apache 2.0. Ciò significa che chiunque abbia trovato i documenti ha ricevuto una “licenza di copyright perpetua, mondiale, non esclusiva, esente da royalty e irrevocabile”, quindi ora sono liberamente disponibili online, come Qui.

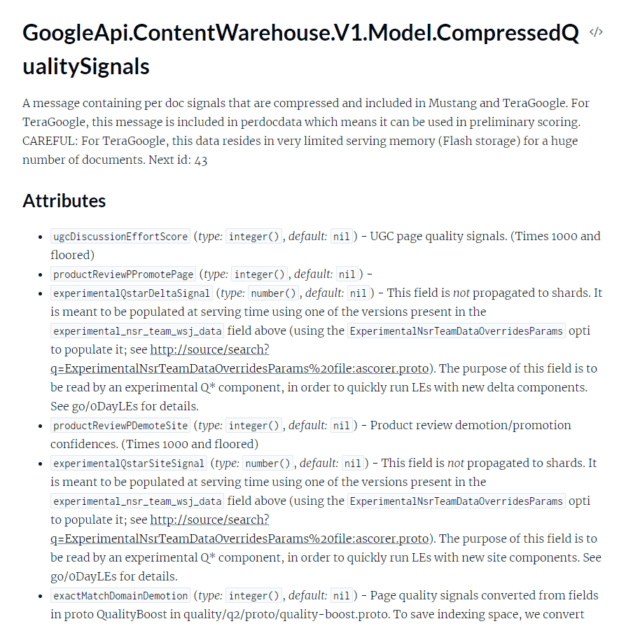

La fuga di notizie contiene molta documentazione API per il “ContentWarehouse” di Google, che è molto simile a un indice di ricerca. Come ci si potrebbe aspettare, anche questa visione incompleta di come Google classifica le pagine web sarebbe incredibilmente complessa. King ha scritto che ci sono “2.596 moduli rappresentati nella documentazione API con 14.014 attributi”. Questi sono tutti documenti scritti da programmatori per programmatori e si basano su molte informazioni di base che probabilmente non conosceresti se non lavorassi in un gruppo di ricerca. La comunità SEO sta ancora studiando i documenti e utilizzandoli per formulare ipotesi su come funziona la ricerca di Google.

Sia Fishkin che King accusano Google di “mentire” in passato agli esperti SEO. Una delle rivelazioni contenute nei documenti è che il CTR di un elenco di risultati di ricerca influisce sul suo posizionamento, che è una cosa di Google Lo ha negato Va a “zuppare” i risultati in più occasioni. Il sistema di tracciamento dei clic si chiama “Navboost”, in altre parole, migliora i siti web visitati dagli utenti. Naturalmente, gran parte di questi dati sui clic provengono da Chrome, anche quando esci dalla ricerca. Ad esempio, alcuni risultati potrebbero mostrare un piccolo insieme di risultati Sitemap sotto il menu principale, parte di ciò che sembra supportare queste pagine secondarie più popolari come determinato dal monitoraggio dei clic di Chrome.

I documenti indicano anche che Google disponeva di liste bianche che avrebbero potenziato artificialmente determinati siti Web per determinati argomenti. I due menzionati sono “isElectionAuthority” e “isCovidLocalAuthority”.

Gran parte della documentazione è esattamente come ti aspetteresti che funzioni un motore di ricerca. I siti hanno un valore “SiteAuthority” che classificherà i siti noti più in alto rispetto ai siti meno popolari. Anche gli autori hanno le loro classificazioni, ma come per tutto qui, è impossibile sapere come tutto interagisce con tutto il resto.

Entrambi i commenti dei nostri esperti SEO li fanno sembrare sconvolti dal fatto che Google li possa indurre in errore, ma l’azienda non ha bisogno di mantenere almeno un rapporto leggermente contraddittorio con le persone che cercano di manipolare i risultati di ricerca? Uno studio recente ha rilevato che “i motori di ricerca sembrano aver perso il gioco del gatto e del topo dello spam SEO” e ha scoperto “una relazione inversa tra il livello di ottimizzazione della pagina e la sua competenza percepita, suggerendo che la SEO potrebbe almeno danneggiare la qualità soggettiva della pagina”. .” Nessuna di questa documentazione aggiuntiva sarà vantaggiosa per gli utenti o per la qualità dei risultati di Google. Ad esempio, ora che le persone sanno che il CTR influisce sul posizionamento nei risultati di ricerca, non potresti potenziare l’elenco del tuo sito web con una click farm?