Unisciti a Leaders a Boston il 27 marzo per una notte esclusiva di networking, idee e conversazioni. Richiedi un invito qui.

Il famoso servizio di generazione di immagini di intelligenza artificiale A metà volo Ha implementato una delle sue funzionalità più richieste: la capacità di ricreare i personaggi in modo coerente attraverso nuove immagini.

Per natura, fino ad oggi questo è stato un grosso ostacolo per i generatori di immagini AI.

Questo perché la maggior parte dei generatori di immagini AI si affidano a “Modelli di diffusione“, strumenti simili o basati sull'algoritmo di generazione di immagini open source Stable AI di Stability AI, Stable Diffusion, che funziona in modo approssimativo prendendo il testo inserito dall'utente e cercando di mettere insieme un'immagine pixel per pixel che corrisponda a quella descrizione, come abbiamo imparato da esperimenti simili con immagini e tag di testo in un gruppo Enormi (e controversi) dati di addestramento comprendenti milioni di immagini generate dall'uomo.

Perché le personalità coerenti sono così potenti – e sfuggenti – per l’intelligenza artificiale generativa

Tuttavia, come con i grandi modelli linguistici basati su testo (LLM) come ChatGPT di OpenAI o il nuovo Command-R di Cohere, il problema con tutte le applicazioni di intelligenza artificiale generativa è l'incoerenza delle risposte: l'IA genera qualcosa di nuovo per ogni singolo prompt inserito in essa. , anche se l'affermazione viene ripetuta o vengono utilizzate alcune delle stesse parole chiave.

Evento V.B

Tour sull'impatto dell'intelligenza artificiale – Boston

Chiedi un invito

Questo è ottimo per creare contenuti completamente nuovi, nel caso di Midjourney, immagini. Ma cosa succede se stai realizzando un film, un romanzo, una graphic novel, un fumetto o qualche altro mezzo visivo che ti piace? Lo stesso Uno o più personaggi attraverso i quali muoversi e apparire in scene e ambientazioni diverse, con espressioni facciali e oggetti di scena diversi?

Questo scenario esatto, solitamente necessario per la continuità narrativa, è stato molto difficile da ottenere utilizzando l’intelligenza artificiale generativa – fino ad ora. Ma Midjourney sta ora lavorando su questo problema, introducendo un nuovo tag, “–cref” (abbreviazione di “riferimento al personaggio”) che gli utenti possono aggiungere alla fine dei loro messaggi di testo in Midjourney Discord e tenteranno di abbinare il volto di un personaggio. Caratteristiche, tipo di corporatura e persino abbigliamento dall'URL che l'utente incolla nel tag menzionato successivamente.

Man mano che la funzionalità progredisce e migliora, Midjourney potrebbe trasformare un gioco interessante o una fonte di idee in uno strumento più professionale.

Come utilizzare la nuova funzionalità di personalità coerente di Midjourney

Il tag funziona meglio con le immagini Midjourney create in precedenza. Quindi, ad esempio, il flusso di lavoro dell'utente sarebbe quello di creare o recuperare l'URL di un carattere generato in precedenza.

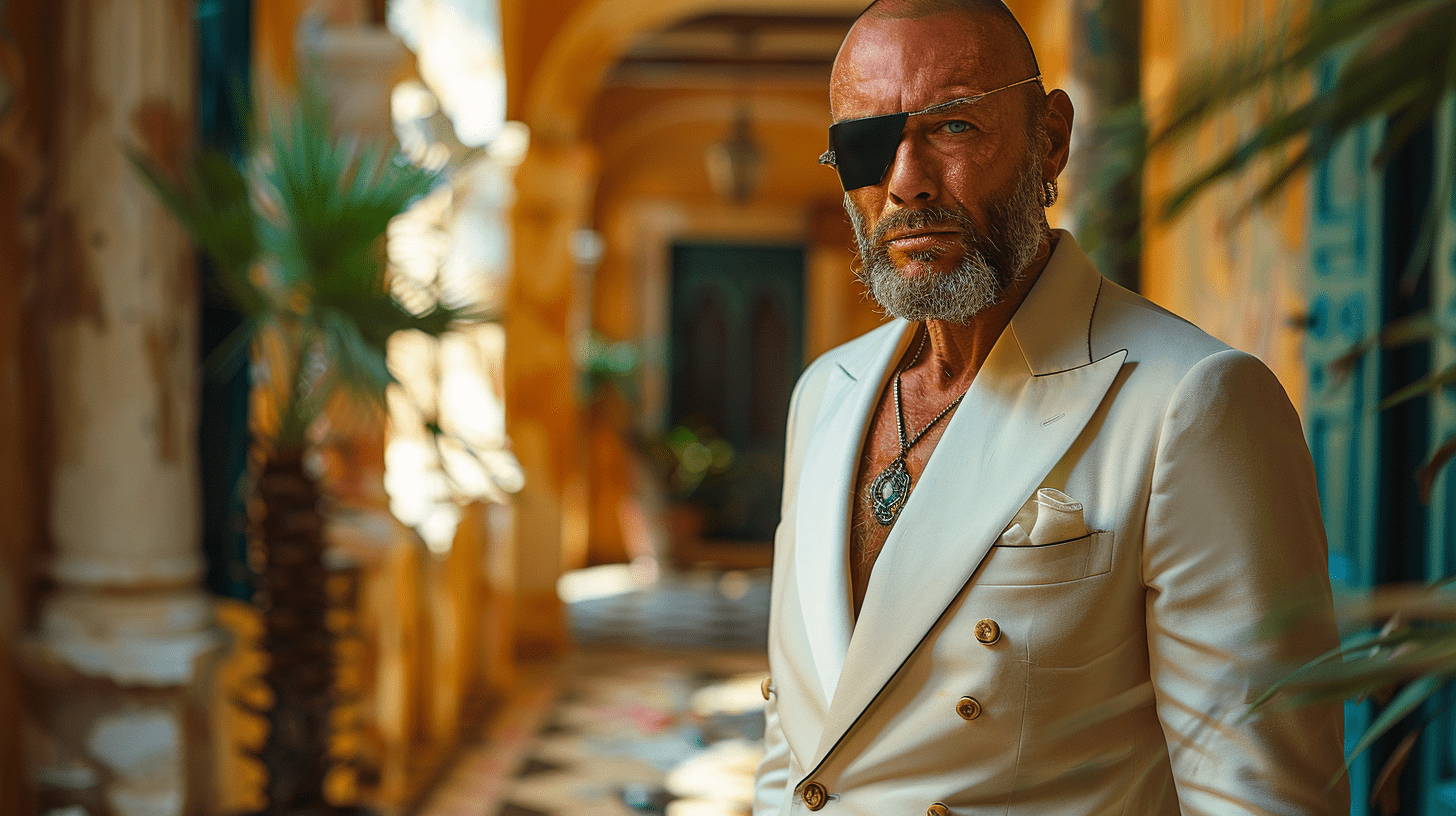

Cominciamo da zero e diciamo che stiamo creando un nuovo personaggio con questo suggerimento: “Uomo calvo e muscoloso con una perla e una benda sull'occhio”.

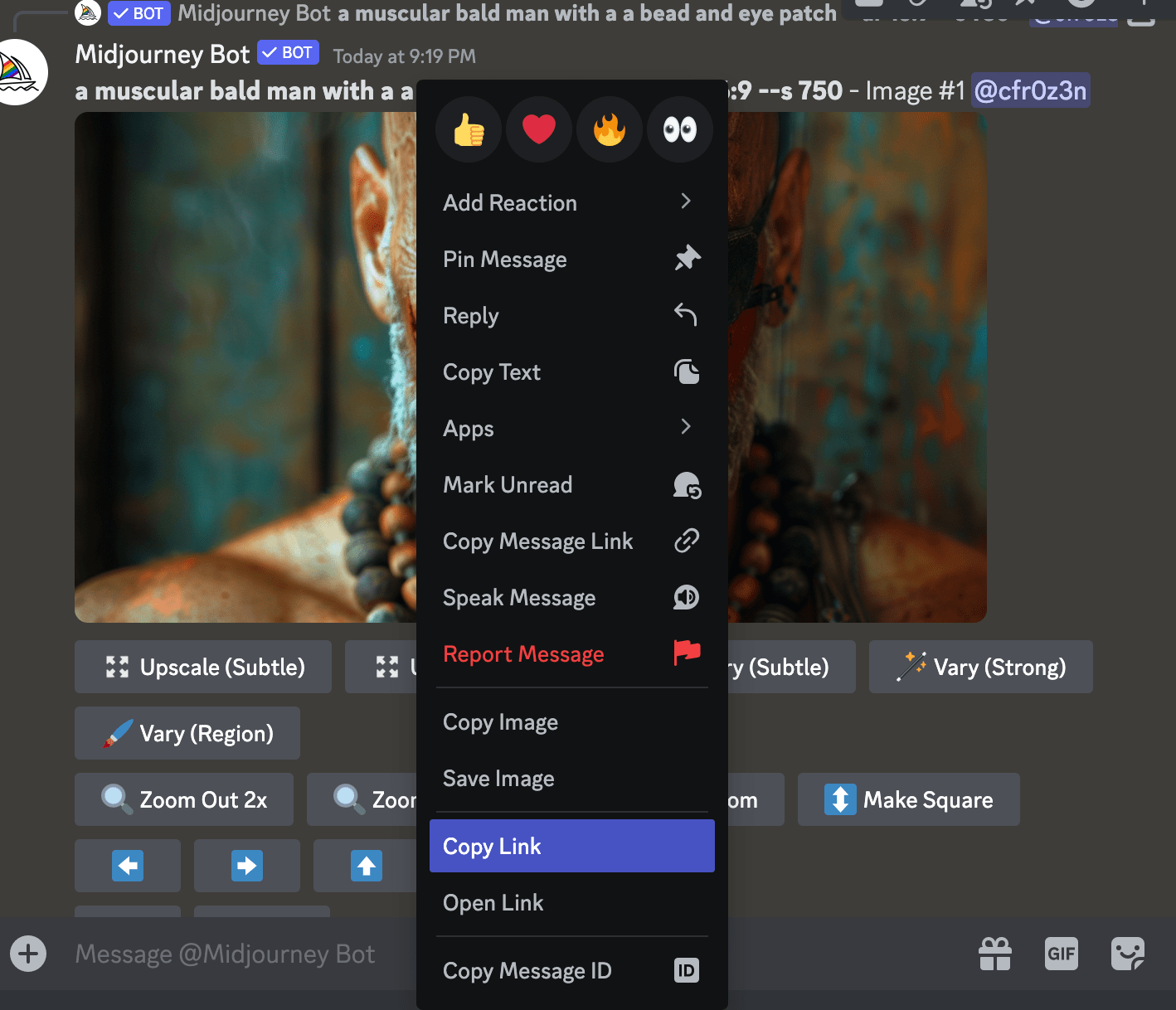

Aggiorneremo l'immagine che ci piace di più, quindi fai clic tenendo premuto il tasto Control su di essa nel server Discord di Midjourney per trovare l'opzione “Copia collegamento”.

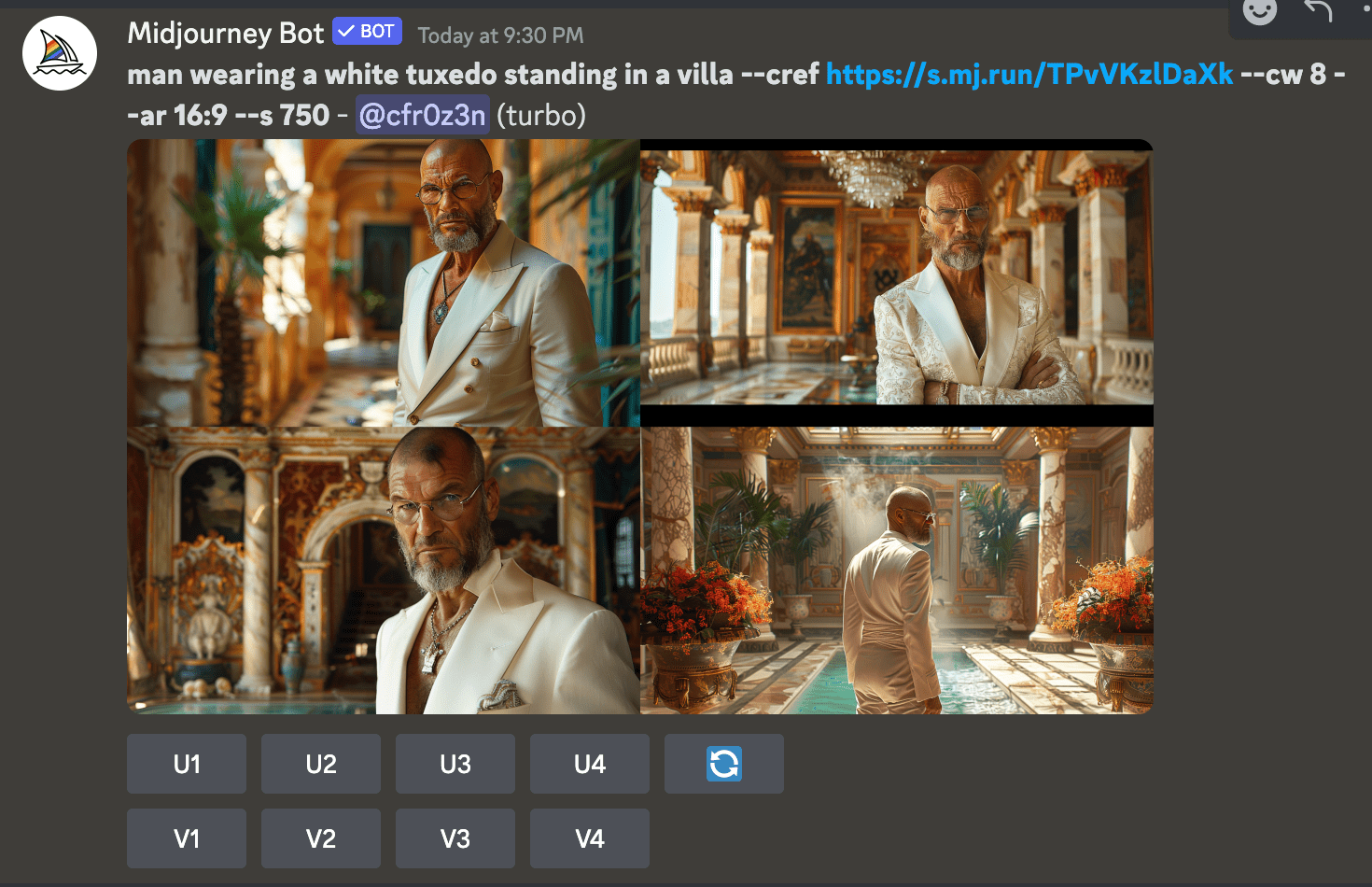

Successivamente, possiamo scrivere un nuovo prompt in “Indossa uno smoking bianco mentre ti trovi in una villa -cref”. [URL]” e incolla l'URL dell'immagine che abbiamo appena creato e Midjourney tenterà di creare lo stesso carattere di prima nell'impostazione appena digitata.

Come vedrete, i risultati sono lontani dal corrispondere alla cifra originale (o anche alla nostra affermazione originale), ma sono certamente incoraggianti.

Inoltre, l'utente può controllare in una certa misura il “peso” di quanto la nuova immagine viene prodotta in modo simile al carattere originale applicando il flag “-cw” seguito da un numero da 1 a 100 alla fine del nuovo prompt ( dopo “-cref [URL]”, quindi così: “-cref [URL] – CW 100.” Più basso è il numero “CW”, maggiore è il contrasto nell'immagine risultante. Più alto è il numero “CW”, più la nuova immagine risultante segue da vicino il riferimento originale.

Come puoi vedere nel nostro esempio, inserendo “cw 8” molto basso in realtà abbiamo restituito ciò che volevamo: lo smoking bianco. Anche se ora ha rimosso la benda sull'occhio caratteristica del nostro personaggio.

Beh, non c'è niente che un'”area diversa” non possa risolvere, giusto?

Ebbene, la benda è stata messa sull'occhio sbagliato… ma ci siamo arrivati!

Puoi anche combinare più caratteri in uno solo utilizzando due tag “–cref” insieme ai rispettivi URL.

La funzionalità è stata lanciata questa sera, ma artisti e creatori la stanno testando ora. Provalo tu stesso se hai Midjourney. E leggi la nota completa del fondatore David Holz sull'argomento di seguito:

Ciao a tutti, oggi stiamo testando la nuova funzione Riferimento al carattere, è simile alla funzione Riferimento al modello, tranne che invece di far corrispondere un modello di riferimento, cerca di far corrispondere il carattere all'immagine del riferimento al carattere.

Come funziona

- Lui scrive

--cref URLDopo che ti è stato richiesto l'URL della tua immagine del profilo - Puoi usare

--cwPer regolare la “forza” del riferimento da 100 a 0 - Forza 100 (

--cw 100) Predefinito e utilizza viso, capelli e indumenti - (fortemente 0)

--cw 0) si concentrerà solo sul viso (ideale per cambiare vestiti/capelli, ecc.)

A cosa serve

- Questa funzione funziona meglio quando si utilizzano personaggi realizzati con immagini di metà viaggio. Non è progettato per persone/immagini reali (e probabilmente le distorcerà come fanno i normali messaggi di immagine)

- Cref funziona in modo simile ai normali messaggi di immagine, tranne per il fatto che si “concentra” sui tratti del carattere

- La precisione di questa tecnica è limitata, non replicherà esattamente fossette/lentiggini/o loghi delle magliette.

- Cref funziona con i normali modelli Niji e MJ e può anche essere combinato con

--sref

Opzioni avanzate

- Puoi utilizzare più di un URL per combinare informazioni/caratteri da più immagini come questa

--cref URL1 URL2(È simile ai suggerimenti per più immagini o stili)

Come funziona su Alpha Web?

- Trascina o incolla un'immagine nella barra di visualizzazione, dove ora contiene tre icone. Specificare questi gruppi se sono un vettore di immagine, un riferimento di stile o un riferimento di carattere. Maiusc+Seleziona un'opzione per utilizzare un'immagine per più categorie

Ricorda, sebbene MJ V6 sia in fase alpha, altre funzionalità potrebbero cambiare improvvisamente, ma la versione beta ufficiale di V6 arriverà presto. Ci piacerebbe condividere i pensieri di tutti su Idee e funzionalità e speriamo che questa versione anticipata ti piaccia e che ti aiuti mentre giochi a costruire storie e mondi

La missione di VentureBeat Sarà una piazza digitale in cui i decisori tecnici potranno acquisire conoscenze sulla tecnologia aziendale trasformazionale e transazionale. Scopri i nostri riassunti.